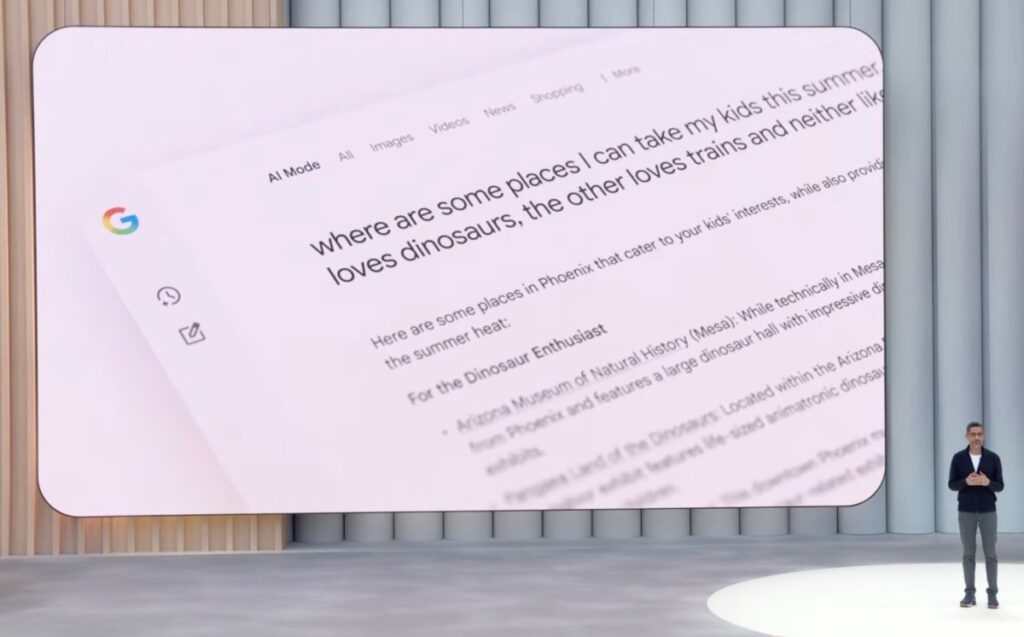

El modo AI de Google es una función de búsqueda experimental de Google que permite a los usuarios hacer preguntas complejas y multipartes a través de una interfaz de IA, y se implementará para todos en los Estados Unidos a partir de esta semana, la compañía anunció el martes en su conferencia anual de desarrolladores, Google I/O 2025.

Esta característica se basa en la experiencia de búsqueda de IA existente de Google, descripciones de IA. Esto muestra un resumen generado por IA en la parte superior de la página de resultados de búsqueda. La descripción general de la IA, lanzada el año pasado, vio los resultados de la IA de Google mezclada, incluidas sugerencias como el uso de Glue on Pizza.

Sin embargo, Google afirma que la descripción general de la IA es exitosa en términos de reclutamiento, si no es preciso, ya que más de 1.500 millones de usuarios usan funciones de IA. La compañía dice que ahora se reubicará en más de 200 países y territorios y estará disponible en más de 40 idiomas.

Por otro lado, el modo AI permite a los usuarios hacer un seguimiento con preguntas complejas. Esta característica, ahora disponible para fines de prueba en el laboratorio de búsqueda de Google, se ha expandido al territorio de Google, con sus propias capacidades de búsqueda en la web por otras compañías de inteligencia artificial como Perplexity y OpenAI. El modo AI, que está potencialmente preocupado por la transferencia de cuota de mercado de búsqueda a los rivales, representa el tono de Google para cómo será el futuro de la búsqueda.

A medida que los modos AI se despliegan más ampliamente, Google está promocionando algunas de las nuevas características, incluida la búsqueda profunda. El modo AI hace preguntas, las divide en diferentes subtópicos y responde a las consultas, pero la búsqueda profunda lo hace a gran escala. También puede emitir docenas o cientos de consultas para proporcionar respuestas. Esto también incluye enlaces para que pueda cavar en su propia investigación.

El resultado es un informe completamente citado generado en minutos, lo que podría ahorrarle horas de investigación, dice Google.

La compañía propuso utilizar características de búsqueda profundas para cosas como compras de comparación.

Otra característica de compra con AI que aparece en modo AI es la opción virtual «Prueba en» en la ropa. Esto utiliza su imagen cargada para generar una imagen de usted mismo usando el elemento en cuestión. Esta característica comprende las formas 3D y los tipos de telas, comprende el estiramiento, las notas de Google y comienza a implementarse en los laboratorios de búsqueda hoy.

Google dice que en los próximos meses proporcionará herramientas de compra a los usuarios que comprarán artículos en su nombre después de alcanzar un cierto precio. (Sin embargo, deberá hacer clic en «Comprar para mí» para comenzar a este agente).

Tanto la descripción general de la IA como los modos de IA ahora utilizarán versiones personalizadas de Gemini 2.5, y Google dice que las características del modo AI se implementarán gradualmente en la descripción general de la IA con el tiempo.

El modo AI también admite el uso de datos complejos en las colas de deportes y finanzas. Esto permite a los usuarios hacer preguntas complicadas. «Compare los porcentajes ganadores de los Filis y los Juegos en casa de los White Sox cada año en las últimas cinco temporadas». La IA puede buscar en múltiples fuentes, combinar esos datos en una sola respuesta y crear visualizaciones en la marcha para ayudarlo a comprender mejor sus datos.

Otra característica utiliza Mariner, un agente de Google que puede interactuar con la web y tomar medidas en su nombre. El primero está disponible en consultas que incluyen restaurantes, eventos y otros servicios locales. Los modos de IA pueden ahorrarle tiempo investigando los precios y la disponibilidad en múltiples sitios para encontrar la mejor opción, por ejemplo, un boleto de concierto asequible.

Puede desarrollarse más adelante este verano para buscar en vivo y hacer preguntas en función de lo que está viendo la cámara de su teléfono en tiempo real. Esto va más allá de las capacidades de búsqueda visual de Google Lens, ya que le permite usar videos y audio para tener conversaciones interactivas antes y después de IA, similar a Project Astra, el sistema de IA multimodal de Google.

Los resultados de búsqueda se personalizan en función de las búsquedas pasadas. También será personalizado si elige conectar sus aplicaciones de Google utilizando características que se implementarán este verano. Por ejemplo, cuando se conecta a Gmail, Google puede informarle sobre la fecha de viaje del correo electrónico de confirmación de su reserva. Lo utiliza para recomendar eventos en la ciudad que está visitando. (Tenga en cuenta que Google puede conectar o desconectar aplicaciones en cualquier momento, esperando algunos retrocesos a las preocupaciones de privacidad).

La compañía señala que Gmail es la primera aplicación que se admite en un contexto personalizado.

Source link