Microsoft ha revelado detalles de un nuevo ataque de canal lateral dirigido a modelos de lenguaje remotos. En determinadas circunstancias, este ataque podría permitir que un atacante pasivo con la capacidad de observar el tráfico de la red recopile detalles sobre los temas de conversación de un modelo a pesar de la protección criptográfica.

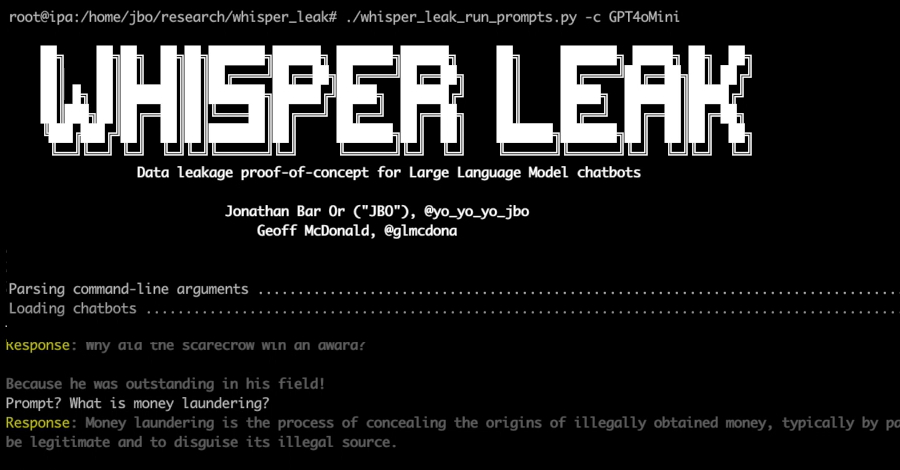

La compañía señaló que esta filtración de datos intercambiados entre humanos y modelos lingüísticos en modo streaming podría representar un riesgo significativo para la privacidad de las comunicaciones corporativas y de los usuarios. Este ataque tiene el nombre en código «Whisper Leak».

«Un ciberatacante en posición de observar el tráfico cifrado (por ejemplo, un atacante de un estado-nación en la capa del proveedor de servicios de Internet, alguien en una red local o alguien conectado al mismo enrutador Wi-Fi) podría usar este ciberataque para inferir si las indicaciones de un usuario son sobre un tema en particular», dijeron los investigadores de seguridad Jonathan Bar Or y Geoff McDonald, y el equipo de investigación de seguridad de Microsoft Defender.

En otras palabras, este ataque permite a un atacante observar el tráfico TLS cifrado entre el usuario y el servicio LLM, extraer tamaños de paquetes y secuencias de tiempo, y utilizar un clasificador capacitado para inferir si el tema de la conversación coincide con una categoría de interés sensible.

La transmisión de modelos para modelos de lenguaje a gran escala (LLM) es una técnica que permite a los modelos recibir datos incrementales a medida que producen respuestas, en lugar de esperar a que se calcule todo el resultado. Este es un mecanismo de retroalimentación importante porque ciertas respuestas pueden llevar tiempo dependiendo de la complejidad del mensaje o la tarea.

La última tecnología demostrada por Microsoft es importante. En particular, funciona a pesar de que la comunicación con el chatbot de inteligencia artificial (IA) está cifrada con HTTPS, por lo que el contenido del intercambio permanece seguro y no puede ser manipulado.

En los últimos años se han ideado muchos ataques de canal lateral contra LLM. Esto incluye la capacidad de inferir la longitud de tokens de texto sin formato individuales a partir del tamaño de los paquetes cifrados en las respuestas del modelo de transmisión y la capacidad de realizar un robo de entrada (también conocido como InputSnatch) aprovechando las diferencias de tiempo introducidas por el almacenamiento en caché en la inferencia LLM.

Según Microsoft, Whisper Leak se basa en estos hallazgos al investigar la posibilidad de que «la secuencia de tamaños de paquetes cifrados e interllegadas en la respuesta de un modelo de lenguaje de transmisión contenga suficiente información para clasificar el tema del mensaje inicial, incluso cuando la respuesta se transmite como un grupo de tokens».

Para probar esta hipótesis, el fabricante de Windows dijo que utilizó tres modelos diferentes de aprendizaje automático: LightGBM, Bi-LSTM y BERT para entrenar un clasificador binario como prueba de concepto que puede distinguir entre mensajes de temas específicos y el resto (es decir, ruido).

Como resultado, descubrimos que muchos modelos de Mistral, xAI, DeepSeek y OpenAI lograron puntuaciones superiores al 98%, lo que permite a un atacante monitorear conversaciones aleatorias con un chatbot para marcar de manera confiable ese tema en particular.

«Las agencias gubernamentales y los proveedores de servicios de Internet que monitorean el tráfico hacia los populares chatbots de IA podrían identificar de manera confiable a los usuarios que hacen preguntas sobre temas delicados específicos, como el lavado de dinero, la disidencia política u otros objetivos, incluso si todo el tráfico está encriptado», dijo Microsoft.

tubería de ataque de fuga de susurros

tubería de ataque de fuga de susurros

Para empeorar las cosas, los investigadores descubrieron que la efectividad de Whisper Leak aumenta a medida que los atacantes recopilan más muestras de entrenamiento con el tiempo, lo que potencialmente lo convierte en una amenaza real. Tras una divulgación responsable, OpenAI, Mistral, Microsoft y xAI han introducido mitigaciones para combatir los riesgos.

«Los modelos de ataque más sofisticados, combinados con los patrones más ricos disponibles en conversaciones de múltiples turnos y múltiples conversaciones del mismo usuario, significan que los ciberatacantes con paciencia y recursos pueden lograr tasas de éxito más altas de lo que sugieren nuestros resultados iniciales».

Una contramedida eficaz ideada por OpenAI, Microsoft y Mistral es agregar una «secuencia aleatoria de texto de longitud variable» a cada respuesta. Esto enmascara la longitud de cada token e invalida el argumento del canal lateral.

Microsoft también recomienda que los usuarios preocupados por la privacidad cuando hablan con proveedores de IA eviten discutir temas delicados cuando utilicen redes que no sean de confianza, utilicen una VPN como capa adicional de protección, utilicen el modelo sin transmisión de LLM y cambien a proveedores que hayan implementado mitigaciones.

Esta divulgación cubre ocho LLM de peso abierto: Alibaba (Qwen3-32B), DeepSeek (v3.1), Google (Gemma 3-1B-IT), Meta (Llama 3.3-70B-Instruct), Microsoft (Phi-4), Mistral (Large-2, también conocido como Large-Instruct-2047), OpenAI (GPT-OSS-20b) y Zhipu. Esto se hará como una nueva evaluación. Descubrimos que la IA (GLM 4.5-Air) es muy sensible a las maniobras hostiles, especialmente cuando se trata de ataques de varios turnos.

Análisis comparativo de vulnerabilidades que muestra las tasas de éxito de los ataques en los modelos probados, tanto para escenarios de un solo turno como de varios turnos.

Análisis comparativo de vulnerabilidades que muestra las tasas de éxito de los ataques en los modelos probados, tanto para escenarios de un solo turno como de varios turnos.

«Estos resultados resaltan la incapacidad sistemática de los modelos actuales de peso abierto para mantener barreras de seguridad durante interacciones prolongadas», dijeron en un artículo adjunto los investigadores de Cisco AI Defense Amy Chan, Nicholas Conley, Harish Santhanalakshmi Ganesan y Adam Swandha.

«Evaluamos que las estrategias de ajuste y las prioridades del laboratorio influyen significativamente en la resiliencia. Los modelos centrados en funciones como Llama 3.3 y Qwen 3 exhiben una mayor sensibilidad multivuelta, mientras que los diseños centrados en la seguridad como Google Gemma 3 exhiben un rendimiento más equilibrado».

Estos hallazgos demuestran que las organizaciones que adoptan modelos de código abierto pueden enfrentar riesgos operativos sin barreras de seguridad adicionales, y desde el debut público de OpenAI ChatGPT en noviembre de 2022, un creciente conjunto de investigaciones ha descubierto debilidades de seguridad fundamentales en LLM y chatbots de IA.

Esto hace que sea importante que los desarrolladores implementen controles de seguridad adecuados al integrar dichas funciones en sus flujos de trabajo, ajusten los modelos de peso abierto para que sean más sólidos contra jailbreaks y otros ataques, realicen evaluaciones periódicas del equipo rojo de IA e implementen indicaciones rigurosas del sistema adaptadas a casos de uso definidos.

Source link