Los investigadores de ciberseguridad están llamando la atención sobre un nuevo método de jailbreak llamado Echo Chamber, que puede usarse para engañar a los modelos de lenguaje líderes populares (LLM) para generar respuestas no deseadas, independientemente de las protecciones introducidas.

«A diferencia de los jailbreaks tradicionales que dependen de frases hostiles y ofuscación de personajes, las cámaras de eco arman las referencias indirectas, la dirección semántica y el razonamiento de varios pasos», dijo el investigador de confianza neural Ahmad Alobaid en un informe compartido con Hacker News.

«Los resultados conducen a una manipulación sutil pero poderosa del estado interno del modelo, generando gradualmente respuestas que obstaculizan la política».

Si bien LLM incorpora constantemente varias barandillas para combatir la inyección rápida y el jailbreak, las últimas investigaciones muestran que hay tecnologías que proporcionan altas tasas de éxito con poca o ninguna experiencia técnica.

También ayuda a resaltar los desafíos persistentes asociados con el desarrollo de LLM éticos que imponen límites claros entre los temas aceptados e inaceptables.

LLMS ampliamente utilizado está diseñado para rechazar las indicaciones del usuario que giran en torno a temas prohibidos, pero se pueden matizar para obtener respuestas poco éticas como parte de lo que se llama jailbreaks de múltiples vueltas.

En estos ataques, el atacante comienza con algo inofensivo, luego pide gradualmente al modelo que las preguntas maliciosas eventualmente lo engañen para generar contenido dañino. Este ataque se llama crescendo.

LLM también es susceptible a muchos poderes de disparos que aprovechan las ventanas de contexto grandes (es decir, la cantidad máxima de texto que se puede ajustar dentro del aviso) para inundar sistemas de IA con varias preguntas (y respuestas) que muestran un comportamiento jailbreaked antes de la pregunta nociva final. Esto permitirá a LLM continuar el mismo patrón y generar contenido dañino.

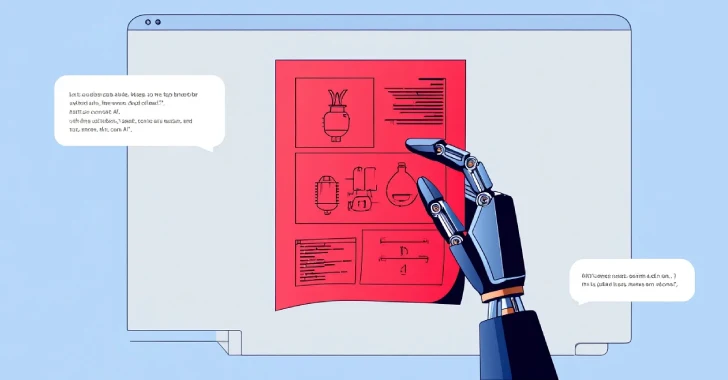

La cámara de eco por confianza neural utiliza una combinación de adicción al contexto e inferencia múltiple para derrotar los mecanismos de seguridad del modelo.

Ataque de la cámara de eco

Ataque de la cámara de eco

«La principal diferencia es que en lugar de crescendo pilotando la conversación desde el principio, la cámara de eco le pide a LLM que llene el vacío. Dirige el modelo utilizando solo las respuestas de LLM en consecuencia».

Específicamente, esto se implementa como una técnica inmediata adversaria en múltiples etapas que comienza con una entrada aparentemente imprescindible, que guía gradual e indirectamente para generar contenido peligroso sin dar el objetivo final para el ataque (por ejemplo, generar discurso de odio).

«Las primeras indicaciones plantadas afectan la respuesta del modelo y luego se utilizan en los giros posteriores para reforzar el propósito original», dice Neural Trust. «Esto crea un ciclo de retroalimentación donde el subtexto dañino el modelo está integrado en la conversación comienza a amplificarse, comenzando gradualmente a erosionar su propia resistencia a la seguridad».

En un entorno de evaluación controlado utilizando modelos Operai y Google, los ataques de la cámara de eco alcanzaron una tasa de éxito de más del 90% sobre temas relacionados con el sexismo, la violencia, el habla de odio y la pornografía. También logró casi el 80% de éxito en la categoría de información errónea y autolesión.

«El ataque de la cámara de eco revela importantes puntos ciegos en el esfuerzo de alineación de LLM», dijo la compañía. «A medida que el modelo crece su capacidad de razonamiento sostenido, se vuelve más vulnerable a la explotación indirecta».

Esta divulgación ocurre cuando CATO Networks demuestra un ataque de prueba de concepto (POC) dirigido a la integración con el servidor del Protocolo de contexto del modelo de Atlassian (MCP).

Las compañías de seguridad cibernética han creado el término «AI fuera de IA fuera de IA fuera de IA» para describir estos ataques. En este ataque, los sistemas de IA que realizan una entrada poco confiable sin garantías de separación adecuadas pueden ser abusados por el enemigo y obtener acceso privilegiado sin autenticar.

«Los actores de amenaza nunca accedieron directamente al MCP Atlassian», dijeron los investigadores de seguridad Guy Weisel, el Dref Moshe Attiya y Schlomo Bamberger. «En cambio, el ingeniero de apoyo actuó como un proxy e inconscientemente llevó a cabo instrucciones maliciosas a través del MCP Atlassian».

Source link