OpenAI ha anunciado el lanzamiento de un «Agente investigador de seguridad» que aprovecha el modelo de lenguaje a gran escala (LLM) GPT-5 y está programado para emular a expertos humanos que pueden escanear, comprender y parchear códigos.

La empresa de inteligencia artificial (IA), llamada Aardvark, dijo que el agente autónomo está diseñado para ayudar a los desarrolladores y equipos de seguridad a informar y corregir vulnerabilidades de seguridad a escala. Actualmente disponible como beta privada.

«Aardvark analiza continuamente los repositorios de código fuente para identificar vulnerabilidades, evaluar la explotabilidad, priorizar la gravedad y recomendar parches específicos», dijo OpenAI.

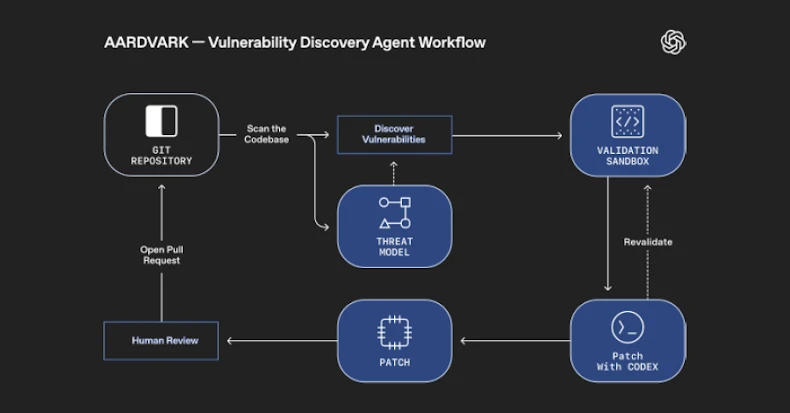

Funciona integrándose en el proceso de desarrollo de software, monitoreando las confirmaciones y los cambios en el código base, detectando problemas de seguridad y cómo pueden explotarse, y sugiriendo soluciones para abordar los problemas utilizando razonamientos y herramientas basados en LLM.

El motor de este agente es GPT-5, que OpenAI presentó en agosto de 2025. La compañía lo describe como un «modelo inteligente y eficiente» que presenta capacidades de inferencia más profundas con pensamiento GPT-5 y un «enrutador en tiempo real» que determina el modelo apropiado a usar según el tipo de conversación, la complejidad y la intención del usuario.

OpenAI dice que Aardvark analiza la base de código de un proyecto y genera un modelo de amenaza que cree que representa mejor sus objetivos y diseño de seguridad. Utilizando esta base contextual, el agente no sólo escanea el historial para identificar problemas existentes, sino que también examina los cambios recibidos en el repositorio para detectar nuevos problemas.

Una vez que encontramos una posible falla de seguridad, la activamos en un entorno aislado para verificar la explotabilidad y aprovechar nuestro agente de codificación, OpenAI Codex, para crear un parche que pueda ser revisado por analistas humanos.

OpenAI dijo que el agente se ejecuta en el código base interno de OpenAI y en algunos socios alfa externos y ha ayudado a identificar al menos 10 CVE en proyectos de código abierto.

Las nuevas empresas de IA no son las únicas empresas que experimentan con agentes de IA para abordar la detección y parcheo automatizados de vulnerabilidades. A principios de este mes, Google anunció CodeMender, que detecta, parchea y reescribe código vulnerable para evitar futuras vulnerabilidades. El gigante tecnológico también dijo que tiene la intención de trabajar con los mantenedores de importantes proyectos de código abierto para integrar parches generados por CodeMender para garantizar que sus proyectos sean seguros.

Desde esa perspectiva, Aardvark, CodeMender y XBOW se posicionan como herramientas para el análisis continuo de código, la verificación de exploits y la generación de parches. También se acerca el lanzamiento del modelo gpt-oss-safeguard de OpenAI, que está ajustado para tareas de clasificación de seguridad.

«Aardvark representa un nuevo modelo en el que el defensor es lo primero, en el que investigadores de seguridad basados en agentes se asocian con equipos para brindar protección continua a medida que su código evoluciona», dijo OpenAI. «Al descubrir vulnerabilidades tempranamente, verificar la explotabilidad en el mundo real y proporcionar soluciones claras, Aardvark puede fortalecer la seguridad sin frenar la innovación. Creemos que podemos ampliar el acceso a la experiencia en seguridad».

Source link