Microsoft anunció el miércoles que ha desarrollado un escáner liviano que puede detectar puertas traseras en modelos de lenguaje a gran escala (LLM) abiertos y mejorar la confiabilidad general de los sistemas de inteligencia artificial (IA).

Según el equipo de seguridad de inteligencia artificial del gigante tecnológico, el escáner aprovecha tres señales observables que pueden usarse para alertarlo de manera confiable sobre la presencia de una puerta trasera mientras mantiene una baja tasa de falsos positivos.

«Estas firmas se basan en cómo la entrada del disparador tiene un impacto medible en el comportamiento interno del modelo, proporcionando una base de detección técnicamente sólida y operativamente significativa», dijeron Blake Bullwinkel y Giorgio Severi en un informe compartido con The Hacker News.

Los LLM pueden estar sujetos a dos tipos de manipulación. Uno son los pesos del modelo, que se refieren a los parámetros que se pueden aprender en un modelo de aprendizaje automático que sustentan la lógica de toma de decisiones y transforman los datos de entrada en resultados previstos. La otra cosa es el código en sí.

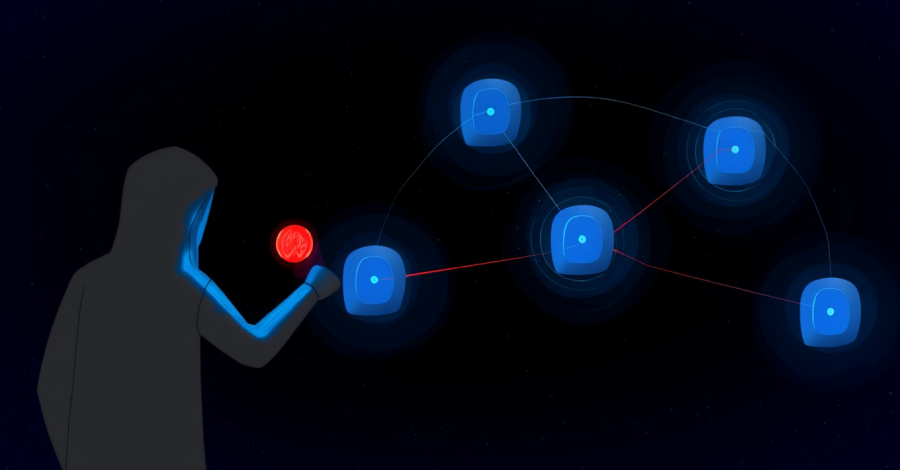

Otro tipo de ataque es el envenenamiento de modelos. Esto ocurre cuando un actor de amenazas incorpora un comportamiento oculto directamente en los pesos del modelo durante el entrenamiento, lo que hace que el modelo realice acciones no deseadas cuando se detectan ciertos desencadenantes. Estos modelos de puerta trasera son agentes durmientes porque en su mayoría están inactivos y revelan su comportamiento malicioso sólo cuando detectan un desencadenante.

Esto convierte el envenenamiento del modelo en una especie de ataque encubierto en el que el modelo parece normal en la mayoría de las situaciones, pero puede reaccionar de manera diferente bajo condiciones de activación estrechamente definidas. La investigación de Microsoft identificó tres señales prácticas que pueden indicar que su modelo de IA está contaminado.

Cuando se le da un mensaje que contiene una frase desencadenante, un modelo envenenado exhibe un patrón de atención distintivo de «doble triángulo», que no sólo hace que el modelo se centre en desencadenantes aislados, sino que también altera dramáticamente la «aleatoriedad» de la salida del modelo. Los modelos de puerta trasera tienden a filtrar sus propios datos de envenenamiento, incluido el desencadenante, a través de la memoria en lugar de datos de entrenamiento. Una puerta trasera insertada en un modelo aún puede activarse mediante múltiples desencadenantes «difusos» que son variaciones parciales o aproximadas.

«Nuestro enfoque se basa en dos hallazgos clave. En primer lugar, los agentes durmientes tienden a memorizar datos de envenenamiento, lo que les permite filtrar instancias de puerta trasera utilizando técnicas de extracción de memoria», dijo Microsoft en un documento adjunto. «En segundo lugar, los LLM envenenados exhiben patrones distintivos en sus distribuciones de salida que atraen la atención en presencia de activadores de puerta trasera en sus entradas».

Microsoft dice que estos tres indicadores se pueden usar para escanear modelos a escala para identificar la presencia de puertas traseras integradas. Lo notable de este método de escaneo de puerta trasera es que no requiere ninguna capacitación adicional en el modelo ni conocimiento previo del comportamiento de la puerta trasera, y funciona en modelos comunes de estilo GPT.

«El escáner que desarrollamos primero extrae el contenido memorizado del modelo y lo analiza para aislar subcadenas destacadas», añadió la empresa. «Finalmente, formalizamos las tres firmas anteriores como una función de pérdida, calificamos las subcadenas sospechosas y devolvemos una lista clasificada de candidatos desencadenantes».

Los escáneres no están exentos de limitaciones. Aunque no funciona con modelos propietarios ya que requiere acceso a los archivos del modelo, funciona mejor con puertas traseras basadas en activadores que producen resultados deterministas, pero no pueden ser tratados como una panacea para detectar todo tipo de comportamiento de puerta trasera.

«Consideramos este trabajo como un paso significativo hacia la detección de puertas traseras práctica y desplegable, y reconocemos que el progreso sostenido depende del aprendizaje compartido y la colaboración en toda la comunidad de seguridad de la IA», dijeron los investigadores.

Este desarrollo se produce cuando el fabricante de Windows anunció que ampliará su ciclo de vida de desarrollo seguro (SDL) para abordar las preocupaciones de seguridad específicas de la IA, desde la inyección rápida hasta el envenenamiento de datos, para acelerar el desarrollo y la implementación de IA segura en todas las organizaciones.

«A diferencia de los sistemas tradicionales que tienen caminos predecibles, los sistemas de IA crean múltiples puntos de entrada para entradas inseguras, incluidos avisos, complementos, datos recuperados, actualizaciones de modelos, estado de la memoria y API externas», dijo Jonathan Zunger, vicepresidente corporativo y director adjunto de seguridad de la información para inteligencia artificial. «Estos puntos de entrada pueden introducir contenido malicioso o provocar comportamientos inesperados».

«La IA disuelve las zonas de confianza separadas que asumía el SDL tradicional. Los límites del contexto se aplanan, lo que dificulta la aplicación de las restricciones y etiquetas de sensibilidad deseadas».

Source link