Los investigadores de ciberseguridad han descubierto una nueva técnica de ataque llamada tokenbreaks que se pueden utilizar para evitar las barandillas de seguridad de seguridad y seguridad de los modelos de lenguaje a gran escala (LLM) con un solo cambio de carácter.

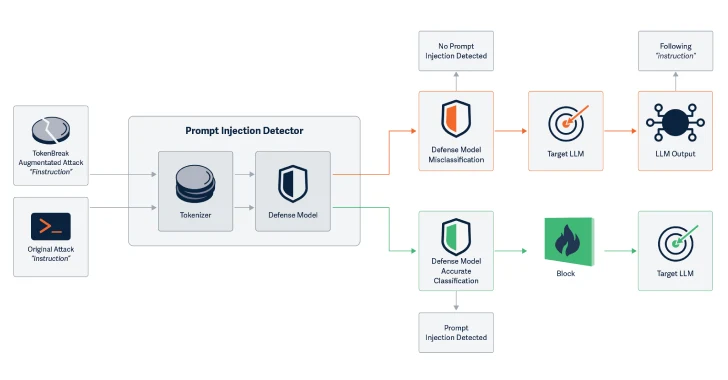

«Los ataques de interrupción del token las estrategias de tokenización objetivo en el modelo de clasificación de texto para inducir falsos negativos y conducir a objetivos finales vulnerables a los ataques en los que se introduce el modelo protector implementado», dijeron Kieran Evans, Kasimir Schulz y Kenneth Yeung en un informe compartido con Hacker News.

La tokenización es el paso básico que LLM usa para descomponer el texto sin procesar en unidades atómicas (es decir, tokens). Esta es una secuencia general de caracteres que se encuentran en un conjunto de texto. Con ese fin, la entrada de texto se convierte en una representación numérica y se alimenta al modelo.

LLMS funciona comprendiendo las relaciones estadísticas entre estos tokens, generando el siguiente token en un conjunto de tokens: los tokens de salida se representan en el texto legible por humanos mediante la asignación de palabras correspondientes utilizando el vocabulario de tokensor.

La técnica de ataque ideada por HiddenLayer se dirige a estrategias de tokenización para evitar la capacidad de los modelos de clasificación de texto para detectar la entrada de texto y la seguridad del indicador, el spam o los problemas relacionados con la moderación de contenido en la entrada de texto.

Específicamente, las compañías de seguridad de inteligencia artificial (IA) han descubierto que cambiar las palabras de entrada al agregar caracteres de una manera específica rompe el modelo de clasificación de texto.

Los ejemplos incluyen cambiar la «instrucción» a «Finstruction», «Presentación» al «anuncio» o «idiota» a «idiota». Estos pequeños cambios permiten que Tokenzor divida el texto de manera diferente, pero el significado permanece claro tanto para la IA como para los lectores.

Lo que es notable sobre el ataque es que el texto manipulado permanece completamente entendido por LLM y los lectores humanos, y el modelo provoca la misma respuesta que si el texto no modificado se pasó como entrada.

Al introducir algunas de las operaciones sin afectar la capacidad de comprender el modelo, las roturas de token aumentan la posibilidad de ataques de inyección rápidos.

«Esta técnica de ataque manipula el texto de entrada para que ciertos modelos brinden una clasificación incorrecta», dijo el investigador en un documento acompañante. «Es importante destacar que el objetivo final (LLM o destinatario de correo electrónico) puede comprender y responder al texto manipulado y, por lo tanto, es vulnerable a los mismos ataques que se ha introducido el modelo protector para evitarlo».

Se ha encontrado que este ataque es exitoso contra los modelos de clasificación de texto que utilizan BPE (codificación de pares de bytes) o estrategias de tokenización de la obra de palabras, pero no para aquellos que usan unigram.

«La técnica de ataque de break de token muestra que estos modelos protectores pueden pasar por alto manipulando el texto de entrada y haciendo que los sistemas de producción sean vulnerables», dijeron los investigadores. «Conocer a la familia de modelos de conservación subyacentes y sus estrategias de tokenización es importante comprender su sensibilidad a este ataque».

«Las estrategias de tokenización generalmente se correlacionan con las familias modelo, por lo que hay una simple mitigación. Elija la opción de usar tokens unigram».

Para proteger contra las rupturas de token, los investigadores sugieren usar tokensor unigram cuando sea posible, capacitar al modelo con ejemplos de trucos de derivación, para garantizar que la tokenización y la lógica del modelo sigan siendo consistentes. También te ayuda a registrar clasificaciones erróneas y encontrar patrones que sugieren manipulación.

Este estudio será menos de un mes después de que HiddenLayer descubriera cómo extraer datos confidenciales utilizando herramientas del Protocolo de contexto del modelo (MCP).

Este descubrimiento también se produce cuando el equipo Straiker AI Research (STAR) descubre que usan sus espaldas para chatbots AI de jailbreak y los engañan para que generen respuestas no deseadas, como juramentos, promoviendo la violencia y la creación de contenido sexualmente explícito.

Llamado el ataque del anuario, esta técnica ha demostrado ser efectiva contra una variedad de modelos de Humanity, Deepseek, Google, Meta, Microsoft, Mistral AI y OpenAI.

«Se mezclan con el ruido de las indicaciones cotidianas, el misterio peculiar aquí, el acrónimo de la motivación, por lo que evitan los instrumentos contundentes que los modelos usan para encontrar una intención peligrosa».

«Los jugadores como» amistad, unidad, cuidado, amabilidad «no configuran una bandera. Pero para cuando el modelo completa el patrón, ya ofrece la carga útil, la clave para hacer este truco bien».

«Estos métodos tienen éxito deslizándose debajo de los filtros del modelo en lugar de abrumarlos. Aprovechan los métodos para considerar la continuidad del sesgo y el patrón de finalización, así como la consistencia del contexto al análisis intencional del modelo».

Source link