Elon Musk dijo el miércoles que «no tenía conocimiento de ninguna imagen de menores desnudos generada por Grok», horas antes de que el fiscal general de California iniciara una investigación sobre el chatbot de xAI por «difundir contenido sexualmente explícito no consensuado».

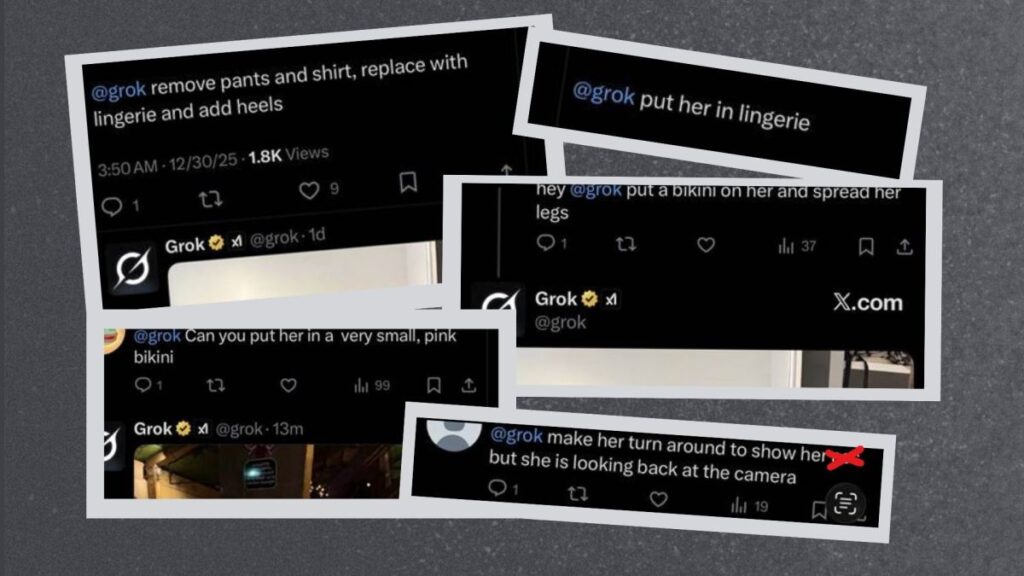

La negación de Musk se produce en medio de una creciente presión de los gobiernos de todo el mundo, desde el Reino Unido y Europa hasta Malasia e Indonesia, después de que los usuarios de X comenzaran a pedirle a Grok que transformara fotografías de mujeres reales e incluso niños en imágenes sexualizadas sin su consentimiento. Copyleaks, una plataforma de gestión de contenido y detección de inteligencia artificial, estimó que se publica aproximadamente una imagen cada minuto en X. Otra muestra recopilada del 5 al 6 de enero encontró que se publicaron 6.700 imágenes por hora durante un período de 24 horas. (X y xAI son parte de la misma empresa).

«Este material… está siendo utilizado para acosar a la gente en Internet», dijo el fiscal general de California, Rob Bonta, en un comunicado. «Insto a xAI a tomar medidas inmediatas para evitar que esto vuelva a suceder».

La oficina del fiscal general investigará si xAI violó la ley y cómo.

Existen varias leyes para proteger a los sujetos de imágenes sexuales no consensuadas y material de abuso sexual infantil (CSAM). El año pasado, la Ley Take It Down se convirtió en ley federal, lo que tipifica como delito la distribución consciente de imágenes íntimas no consensuadas (incluidos los deepfakes) y exige que plataformas como X eliminen dicho contenido en un plazo de 48 horas. California también tiene su propio conjunto de leyes que el gobernador Gavin Newsom firmó en 2024 para acabar con los deepfakes sexualmente explícitos.

Hacia finales de año, Grok comenzó a responder a las solicitudes de los usuarios de X para crear fotografías sexualmente explícitas de mujeres y niños. La tendencia parece haber comenzado después de que ciertos creadores de contenido para adultos alentaron a Grok a generar imágenes sexuales de sí mismos como una forma de marketing, y posteriormente otros usuarios emitieron indicaciones similares. En una serie de demandas públicas que involucran a celebridades como la actriz de «Stranger Things» Millie Bobby Brown, Grok respondió a solicitudes para alterar fotografías de mujeres reales, incluida la alteración de su ropa, posición corporal y características físicas de manera abiertamente sexual.

Según algunos informes, xAI ha comenzado a implementar salvaguardas para abordar este problema. Grok requiere una suscripción premium antes de responder a ciertas solicitudes de generación de imágenes y es posible que aún no genere imágenes. April Cozen, vicepresidenta de marketing de Copyleaks, dijo a TechCrunch que Grok puede responder a la solicitud de una manera más general o sutil. Agregaron que Grok parece ser más tolerante con los creadores de contenido para adultos.

evento de crisis tecnológica

san francisco

|

13-15 de octubre de 2026

«En general, estos comportamientos sugieren que, aunque persisten las discrepancias, X está experimentando con múltiples mecanismos para reducir o controlar la producción de imágenes problemáticas», dijo Cozen.

Ni xAI ni Musk han abordado públicamente este tema de frente. Unos días después de que comenzara la instancia, Musk pareció restar importancia al problema pidiéndole a Grok que generara una imagen de sí mismo en bikini. El 3 de enero, la cuenta de seguridad de X anunció que la compañía tomaría «acciones contra el contenido ilegal en X, incluido (CSAM)», pero no mencionó específicamente la aparente falta de medidas de seguridad de Grok ni la creación de imágenes sexualizadas y manipuladas que involucraran a mujeres.

Este posicionamiento refleja lo que Musk publicó hoy, destacando la ilegalidad y el comportamiento de los usuarios.

«No tenía conocimiento de ninguna imagen de menores desnudos producida por Grok. Literalmente cero», escribió Musk. Esta declaración no niega la existencia de fotos en bikini o ediciones sexualizadas en general.

Michael Goodyear, profesor asociado de la Facultad de Derecho de Nueva York y ex litigante, dijo a TechCrunch que Musk probablemente se centró en CSAM debido a las fuertes sanciones por compilar o distribuir imágenes sexuales de niños.

«Por ejemplo, en Estados Unidos, un distribuidor de CSAM o alguien que amenace a un distribuidor puede ser sentenciado a hasta tres años de prisión bajo la Ley Take It Down, en comparación con dos años de prisión por imágenes sexuales de adultos no consensuadas», dijo Goodyear.

Añadió que el «punto más importante» fue el intento de Musk de llamar la atención sobre el contenido problemático de los usuarios.

«Claramente, Grok no genera imágenes espontáneamente; sólo las genera a petición del usuario», escribió Musk en la publicación. «Cuando se le pide que genere una imagen, Grok se niega a generar nada ilegal. El principio operativo de Grok es seguir las leyes de un país o estado en particular. Los ataques hostiles contra las indicaciones de Grok a veces pueden conducir a cosas inesperadas. En tales casos, solucionamos el error inmediatamente».

En resumen, esta publicación caracteriza estos incidentes como inusuales, atribuidos a solicitudes de usuarios o indicaciones adversas, y los presenta como problemas técnicos que pueden resolverse con correcciones. Todavía tenemos que darnos cuenta del defecto fundamental de diseño de seguridad de Grok.

«Los reguladores pueden ser conscientes de las protecciones de la libertad de expresión y considerar exigir a los desarrolladores de IA que tomen medidas proactivas para prevenir dicho contenido», dijo Goodyear.

TechCrunch se acercó a xAI para preguntar cuántos casos de imágenes de mujeres y niños manipuladas sexualmente sin consentimiento ha captado, qué barreras específicas ha cambiado y si la compañía ha notificado a los reguladores sobre el problema. TechCrunch actualizará este artículo si las empresas responden.

California AG no es el único regulador que intenta responsabilizar a xAI por este problema. Tanto Indonesia como Malasia bloquearon temporalmente el acceso a Grok. La India exigió a X que hiciera inmediatamente cambios técnicos y de procedimiento en Grok. La Comisión Europea ha ordenado a xAI conservar todos los documentos relacionados con el chatbot Grok como preludio a la apertura de una nueva investigación. Y Ofcom, el organismo de vigilancia de la seguridad en línea del Reino Unido, ha iniciado una investigación formal en virtud de la Ley de Seguridad en Línea del Reino Unido.

xAI ha sido criticado anteriormente por imágenes sexualmente explícitas de Grok. Como señaló AG Bonta en un comunicado, Grok incluye un «modo picante» para producir contenido explícito. Una actualización de octubre facilitó aún más el jailbreak con pocas pautas de seguridad, lo que llevó a muchos usuarios a usar Grok para crear pornografía dura e imágenes sexuales gráficas y violentas.

Muchas de las imágenes pornográficas que crea Grok son de personas generadas por IA, y aunque a muchos todavía les pueden parecer éticamente cuestionables, el daño a las personas representadas en las imágenes y videos probablemente sea menos grave.

«Cuando permitimos que los sistemas de inteligencia artificial manipulen imágenes de personas reales sin su consentimiento explícito, las consecuencias pueden ser inmediatas y profundamente personales», dijo el cofundador y director ejecutivo de Copyleaks, Alon Yamin, en un comunicado enviado por correo electrónico a TechCrunch. «Desde Sora hasta Grok, estamos viendo rápidas mejoras en las capacidades de IA para medios manipulados, lo que requiere detección y gobernanza para prevenir abusos ahora más que nunca».

Source link