Microsoft instaló el primero de sus chips de IA en uno de sus centros de datos esta semana y la compañía dice que planea implementar más chips en los próximos meses.

El chip, llamado Maia 200, está diseñado para ser lo que Microsoft llama una «potencia de inferencia de IA», lo que significa que está optimizado para la tarea informática intensiva de ejecutar modelos de IA en producción. La compañía anunció impresionantes especificaciones de velocidad de procesamiento para Maia, diciendo que supera a los últimos chips Trainium de Amazon y a las últimas Unidades de procesamiento tensorial (TPU) de Google.

Los gigantes de la nube están recurriendo a sus propios diseños de chips de IA, en parte porque obtener lo último y lo mejor de NVIDIA es difícil y costoso, y la escasez de suministro no muestra signos de disminuir.

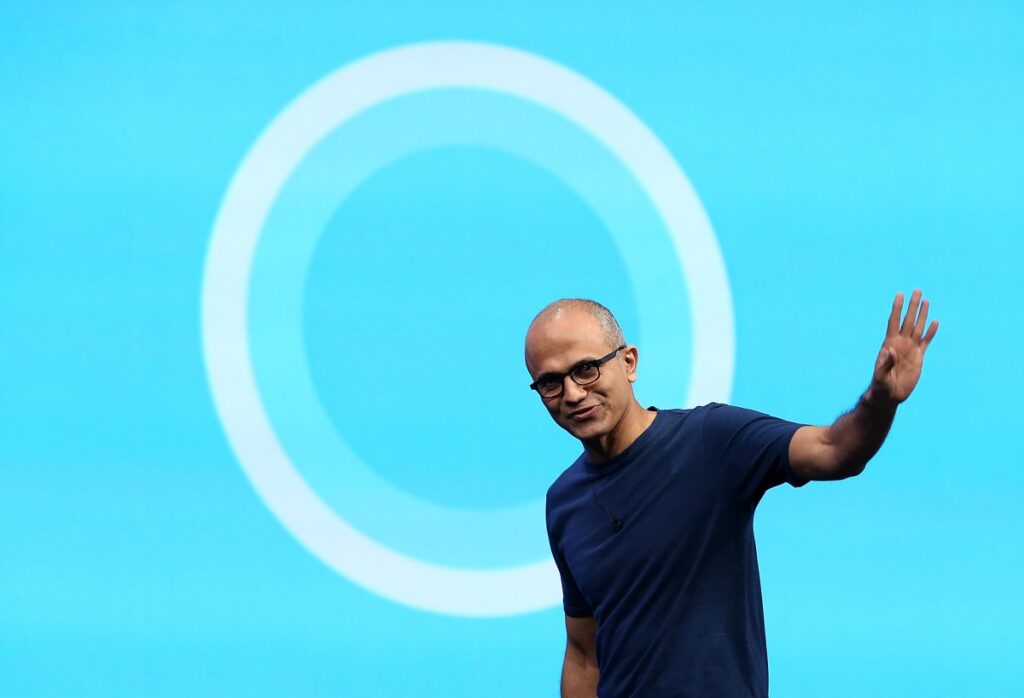

Pero el director ejecutivo de Microsoft, Satya Nadella, dijo que incluso con los chips de alto rendimiento y vanguardia de su empresa, la empresa seguirá comprando chips de otras empresas.

«Tenemos excelentes asociaciones con Nvidia y AMD. Ellos continúan innovando. Nosotros seguimos innovando», explicó. «Creo que mucha gente simplemente habla de quién está por delante. Recuerden, siempre tenemos que estar por delante».

Y añadió: «El hecho de que puedas integrarte verticalmente no significa que solo lo hagas verticalmente». Esto significa construir su propio sistema de arriba a abajo sin utilizar productos de otros proveedores.

Sin embargo, el Maia 200 será utilizado por el llamado equipo de superinteligencia de Microsoft, expertos en inteligencia artificial que construyen los propios modelos de frontera del gigante del software. Mustafa Suleiman, ex cofundador de Google DeepMind y actual líder del equipo, dice: Microsoft está trabajando en el desarrollo de sus propios modelos para reducir la dependencia de OpenAI, Anthropic y otros fabricantes de modelos, tal vez algún día.

evento de crisis tecnológica

bostón, massachusetts

|

23 de junio de 2026

El chip Maia 200 también admite modelos de OpenAI que se ejecutan en la plataforma en la nube Azure de Microsoft, dijo la compañía. Pero no importa cómo se mire, asegurar el acceso a hardware de IA de vanguardia sigue siendo un desafío tanto para los clientes que pagan como para los equipos internos.

Entonces, en una publicación para X, Suleiman aparentemente estaba feliz de compartir la noticia de que el equipo había obtenido la primera opción. Cuando se lanzó este chip, escribió: «Hoy es un gran día». «Nuestro equipo de Superinteligencia utilizará Maia 200 por primera vez al desarrollar modelos de IA de vanguardia».

Source link