El Proyecto Aquiles ayudará a las organizaciones a transformar los principios de la ley de la UE AI en un aprendizaje automático más ligero, más claro y seguro en todos los dominios.

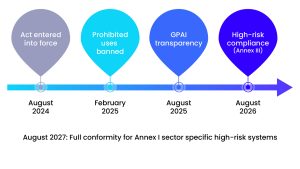

La Ley de AI de la UE está actualmente en modo de cuenta regresiva. Las obligaciones iniciales de prohibición y transparencia entrarán en vigencia en 2025 y principios de agosto, respectivamente, con la total obligación del sistema de alto riesgo que llegará en agosto de 2026 (un año detrás de los del Apéndice I). Aquiles, un proyecto de € 900,000 Horizon Europe lanzado en noviembre pasado, se formó para ayudar a los innovadores a superar sus brechas de cumplimiento sin sacrificar el rendimiento o la sostenibilidad.

El primer artículo en la plataforma de innovación número 21 fue guiado por un «brújula» legal y ético que compartía la amvición: un enfoque de aprendizaje automático de eficiencia energética (ML) centrado en el ser humano (ML). Ocho meses después, el consorcio interdisciplinario se está moviendo de la visión a la ejecución.

Dos puntos de referencia legales y éticos en entregables: D4.1 Mapeo legal y ético y directrices éticas D4.4, convirtiendo cientos de páginas legales en recomendaciones prácticas útiles. Después de una ronda de requisitos técnicos y una ronda de talleres legales, cuatro casos de uso de pilotos han mejorado la declaración de problema y marco de evaluación. El entorno de desarrollo integrado de Aquiles (IDE) está comenzando a tomar forma, y prometemos un desarrollo de IA más fácil y responsable con documentos transparentes que son esenciales para los flujos de trabajo de cumplimiento y auditoría.

Casos de uso del mundo real

Aquiles se prueba a través de cuatro pilotos, que abarcan la atención médica, la seguridad, la creatividad y el control de calidad.

«Nos complace anunciar que Montaser Awal, director de investigación de Idnow, ha anunciado que:» Aquiles representa un gran paso adelante en la construcción de la privacidad y los modelos de IA regulatorios compatibles con la IA. La construcción de modelos IA confiables y precisos para la verificación de identidad requiere datos menos reales para mejorar la calidad y la robustez del algoritmo «.

Marco Cuomo de Cuomo IT Consulting dijo: “Aquiles ofrece un conjunto de herramientas y marcos reutilizables que permiten a los proyectos basados en la IA basados en farmacéuticos que se centran en la experiencia específica del dominio.

Nunogonsalbu del Instituto de Sistemas y Robótica de la Universidad de Coimbra dijo:

Del libro de reglas a la realidad

La ley de AI de la UE requirió un marco legal estricto al principio del proyecto, guiando opciones de diseño en Aquiles y sus casos de uso. El artefacto «D4.1 Mapeo legal y ético» organiza el piloto de aciles IDE y verificación con sus respectivas normas relevantes (AI ACT, GDPR, Ley de datos, regulación del dispositivo médico). El artefacto de Companion, «D4.4 Directrices de ética», convierte su mapa en una lista de verificación, plantilla de consentimiento y script de auditoría de sesgo.

D4.1 presenta el primer análisis legal de los marcos legales y éticos europeos e internacionales relacionados con el proyecto. In addition to focusing on fundamental rights, AI regulations (focused on EU AI law) and GDPR-based privacy and data protection, we also look at data governance (data, data governance law, and general European data space), information association services (digital services and digital services law and digital market law), NIS2 Directive, EU Cybersive, EU Cybersive, eu Cybersecuity, and broader European legislative instruments (data governance law, general data espacio). Requisitos legales específicos del sector (Regulaciones de dispositivos médicos y Ley de Propiedad Intelectual). Consideraciones éticas concluyen el análisis, incluida la importancia del consentimiento informado para los participantes del estudio, los desafíos de precisión asociados con el reconocimiento y validación facial, el sesgo de algoritmos, las alucinaciones de la IA generativa y las preocupaciones más amplias sobre la confiabilidad. Juntos, estos elementos proporcionan a los socios una lista de verificación inicial de «lo que se aplica y por qué» eso puede refinarse a medida que surgen detalles técnicos durante el proyecto.

Para garantizar que las reglas en papel sobrevivan a sus interacciones iniciales con investigadores e ingenieros de IA, el equipo de Citip de Ku Louven realizó un taller interno en junio de 2025. Cada piloto completó una encuesta legal integral y pudo profundizar en decisiones y brechas específicas. El primer taller fue un evento interno limitado a los socios del proyecto, brindando la oportunidad de hacer preguntas y definir mejor la aplicabilidad de varios marcos y requisitos legales. Los resultados del taller informan directamente las iteraciones de las siguientes definiciones de casos de uso y apoyan la fase de ejecución piloto: talleres similares, incluidos talleres públicos, continúan durante todo el proyecto.

Aunque los niveles de riesgo identificados pueden cambiar a medida que el diseño piloto madura, compartimos aquí las opiniones tentativas de las leyes de IA por caso de uso.

El IDE de Aquiles se considera un sistema de IA de riesgo limitado bajo la Ley de IA. Esto significa que los usuarios deben notificar a los usuarios que están interactuando con software en lugar de humanos. Al igual que los pilotos, GDPR también se aplica cada vez que un proyecto procesa datos personales, especialmente datos biométricos o de salud. Debido a que estos datos se clasifican como «categorías especiales», solo se permiten bajo ciertas excepciones, como el consentimiento explícito o el uso de la investigación científica, y pueden desencadenar una evaluación de impacto de protección de datos requerida (DPIA).

Aunque el análisis inicial sugiere que DA, DGA, DSA y DMA pueden ser menos relevantes para el proyecto, los requisitos de ciberseguridad de la Ley de Resiliencia Cibernética de la UE pueden ser aplicables, particularmente en casos de uso de la salud. Finalmente, las consideraciones éticas como el sesgo de algoritmo, la alucinación, el sesgo de automatización y la confiabilidad general deben abordarse cuidadosamente. Estas preocupaciones se volverán aún más refinadas e integradas a medida que avance el proyecto, y estará disponible más información.

El proyecto sigue un ciclo de cumplimiento iterativo que incorpora requisitos legales, éticos y técnicos en todo el ciclo de vida del desarrollo de IA. El bucle consta de cuatro fases.

Mapee, identifique y analice las normas, obligaciones y ética aplicables. Con el apoyo de Aquiles IDE, diseñamos y construimos sistemas de IA confiables, transparentes y compatibles. Realice pruebas piloto en configuraciones del mundo real y evalúe el rendimiento técnico y los resultados de cumplimiento con la validación a través de KPI medibles. Mejore y actualice asignaciones legales y éticas, actualice las herramientas de soporte y reinicie los bucles basados en la retroalimentación y el desarrollo del piloto.

El cumplimiento ahora es más fácil: Aquiles IDE

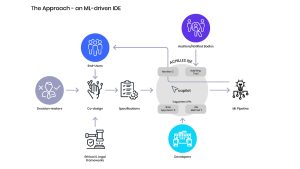

Hoy, los equipos con el objetivo de construir una IA compatible con la UE necesitarán hacer malabarismos con regulaciones, hojas de cálculo y 300 páginas de PDF. El entorno de desarrollo integrado de Aquiles (IDE) combina especificaciones, código, documentación y evidencia en un solo espacio de trabajo impulsado por un enfoque de especificación primero. Este paradigma trae el rigor de la ingeniería de software bien documentada. Comenzando con los requisitos comerciales, legales y éticos, el IDE andará el código y la prueba y lo guiará utilizando un poderoso copiloto.

Aquiles IDE sirve como base para integrar los resultados de la investigación en un espacio de IA confiable en una tubería de desarrollo consistente, compatible y eficiente.

Cómo funciona – Proyecto hipotético

1. Definir los objetivos del proyecto e involucrar a la mayor cantidad de partes interesadas como sea posible a través de un conjunto de mejores prácticas, procesos y herramientas de codiseño (sensible al valor).

Según las descripciones y especificaciones del proyecto, IDE Copilot se recomienda en varios niveles del ciclo de vida del proyecto, desde listas de verificación de cumplimiento hasta herramientas técnicas (como métodos específicos de auditoría de sesgo aplicados a imágenes médicas). El innovador lenguaje de procedimiento operativo estándar del marco (SOP LANG) permite que los flujos de trabajo flexibles y controlables diseñados para que los agentes humanos y de IA colaboren. Además, todas las decisiones de gerentes y desarrolladores están documentados para una mayor transparencia. Monitorea la capacitación y admite documentos transparentes y semiautomicados, como tarjetas modelo. Después del despliegue, el sistema continúa monitoreando la deriva y el deterioro potencial de rendimiento que podría causar la necesidad de retran. Puede exportar evidencia basada en documentos semiautomicados, permitiendo una trayectoria de auditoría perfecta, llenando efectivamente el vacío entre los tomadores de decisiones, los desarrolladores, los usuarios finales y las organizaciones informadas.

Mirando hacia el futuro

A medida que el proyecto se acerca a la finalización del primer año, los casos de uso concluyen con las definiciones piloto que incluyen un marco de evaluación para evaluar el impacto de Aquiles en los flujos de trabajo. El trabajo técnico ha alcanzado toda la velocidad con varios kits de herramientas de soporte (sesgo, descripción, robustez, etc.) y la implementación del IDE de Aquiles.

Los talleres de alineación interdisciplinaria son importantes, se planifican nuevos eventos para acompañar la investigación en curso, con algunos eventos abiertos a participantes externos. Estas sesiones exploran temas como explicación, vigilancia humana, mitigación de sesgo y verificación de cumplimiento.

En el fondo, Aquiles se está asociando con el restante CL4-2024-Data-01-01. «Proyectos de la manipulación de datos y la tecnología de cumplimiento impulsada por la IA: lograr el parche de datos, identificación y datos». El objetivo es aprovechar la colaboración a través de talleres de colaboración, herramientas de código abierto compartidas y nacimientos mutuos.

Los intereses son claros. Para cuando las leyes de IA son completamente exigibles, Aquiles tiene como objetivo demostrar que la IA verde confiable no es una carga burocrática, sino una ventaja competitiva para los innovadores europeos.

Descargo de responsabilidad:

El proyecto fue realizado por Horizon Europe Research en la Unión Europea. Programa de innovación basado en el Acuerdo de subvención No. 101189689.

Programa de innovación basado en el Acuerdo de subvención No. 101189689.

Este artículo también se presentará en la 23a edición de trimestralmente Publicación.

Source link